降AI不伤专业术语怎么做到?保姆级教程从原理到实操

我改了五遍论文,AI率从45%涨到了62%。

不是我改得不够多,而是方向错了。每一轮修改,工具都在偷偷把「PCR扩增条件」改成「基因复制实验环境」,把「鲁棒性」改成「健壮性」——导师一看就知道不对。后来我换了个思路,用语义重构降AI的方法配合比话降AI(www.bihuapass.com)的Pallas引擎,一次搞定:AI率降到12%,术语一个没动。

这篇教程把我踩过的坑和最后摸索出来的降AI工作流全部整理出来,从原理讲到实操,你照着做就行。

为什么降AI总会伤到专业术语?

要解决问题,先得搞清楚问题出在哪。

大部分降AI工具的底层逻辑是「同义词替换+句式微调」。这套方法对日常用语很有效,但碰到专业术语就翻车了。原因很简单:通用语言模型的训练语料里,「回归分析」和「回溯分析」、「正态分布」和「常态分配」长得差不多,模型分不清哪个是学术规范用法。

实际踩坑中最常见的术语误改有这几类:

- 方法论术语被改:回归分析 → 回溯分析,卷积神经网络 → 折叠神经网

- 统计学术语被改:鲁棒性 → 健壮性,正态分布 → 常态分配

- 学科专用名词被改:PCR扩增 → 基因复制扩大,有限元分析 → 有限单元分析法

这就是为什么很多人改了三四遍,AI率不降反升——每次改完工具乱动术语,你再手动改回来,改来改去文本反而越来越「规律化」,检测算法更容易抓到。

语义重构降AI的核心原理

语义重构和简单换词是两码事。

AIGC检测算法抓的不是某个词,而是「统计学特征」——句式长度的均匀度、过渡词的使用频率、论证路径的标准化程度。AI生成的文本有个典型特征:句长标准差很小(大概1.2左右),而人类写作通常在4-5之间波动。

语义重构的做法是:保留所有专业术语和核心论据不动,只改变表达的「节奏」和「路径」。

打个比方,AI写的段落通常是「提出观点 → 给论据 → 得结论」,像教科书一样工整。语义重构会把它改成人类更自然的写法:先抛一个具体案例,再从案例里提炼观点,或者先说结论再补论据。术语还是那些术语,数据还是那些数据,但整个段落的「统计指纹」变了。

这也是比话降AI的Pallas NeuroClean 2.0引擎在做的事。它基于改进的Transformer架构,用动态语义熵平滑技术来调整文本的困惑度和突发性(这两个指标是AIGC检测的核心判据),同时内置术语保护机制,确保专业词汇不被动。

降AI不伤专业术语的三步工作流

下面是我实测有效的降AI工作流,三步走完,术语保护和AI率都能到位。

第一步:标注术语清单。 在处理之前,把论文里所有不能改的专业术语列一个清单。包括但不限于:核心概念(如「回归分析」「支持向量机」)、研究方法(如「双盲实验」「因子分析」)、量表和模型名称(如「李克特五点量表」「ARIMA模型」)、缩写及其全称。这个清单不用很精细,花10分钟过一遍就行,主要是让你心里有数哪些词绝对不能动。

第二步:分段处理 + 工具降AI。 打开比话降AI(www.bihuapass.com),上传论文。Pallas引擎会自动处理全文,通常2分钟出结果。这里有个技巧:如果某些段落术语特别密集(比如实验方法部分),可以单独把这些段落提取出来,降低处理强度或者干脆手动微调。术语稀疏的段落(比如文献综述、讨论部分)就放心交给工具处理。

第三步:术语核对 + 人工复核。 处理完之后,拿出第一步的术语清单,在处理后的文本里逐一搜索核对。一万字的论文,这个过程大概半小时。重点盯几类容易出问题的地方:新出现的概念和缩写(工具可能没见过)、跨学科借用的术语、公式前后的变量说明。

这三步走下来,实测一篇含PCR扩增条件的医学论文,AI率从65%降到18%,术语零误改。

不同学科的术语保护要点

不同学科的专业术语差别很大,降AI时的保护策略也不一样。

| 学科类型 | 重点保护术语 | 常见误改案例 | 建议处理方式 |

|---|---|---|---|

| 计算机/人工智能 | 算法名称、模型架构 | 卷积神经网络→折叠神经网 | 算法名称全部标注保留 |

| 医学/生物 | 病理名词、实验方法 | PCR扩增→基因复制扩大 | 实验方法段落轻度处理 |

| 经济/管理 | 量表名称、统计方法 | 回归分析→回溯分析 | 标注所有统计方法术语 |

| 法学 | 法条引用、法律概念 | 善意取得→好意取得 | 法条部分不处理 |

| 工科/物理 | 公式变量、实验参数 | 有限元分析→有限单元分析法 | 公式段落跳过不处理 |

理工科论文还有一个容易忽略的地方:图表说明文字。比如「图3展示了不同温度下的应力-应变曲线」,这种句子里的「应力-应变曲线」是术语,但「展示了」「不同温度下」这些描述性语言可以改。处理时要注意区分。

工具选择:哪些降AI工具对术语更友好

市面上降AI工具不少,但对术语保护的重视程度差别很大。我把自己用过的几款整理成表格,方便你按需选择。

| 工具名称 | 术语保护能力 | 知网AI率目标 | 价格 | 适合场景 |

|---|---|---|---|---|

| 比话降AI | 强(Pallas引擎+术语保护) | <15% | 8元/千字 | 知网检测、术语密集论文 |

| 嘎嘎降AI | 强(领域自适应模型) | <20% | 4.8元/千字 | 多平台检测、一般学术论文 |

| 率零 | 中(DeepHelix引擎语义重构) | 个位数 | 2元/千字起 | 预算有限、长篇论文 |

| 率降 | 中(BalanceWrite引擎) | <20% | 4.2元/千字 | 本科论文、一般需求 |

| PaperRR | 强(AcademicCore+术语智能保护) | <15% | 6元/千字 | 硕博论文、高要求场景 |

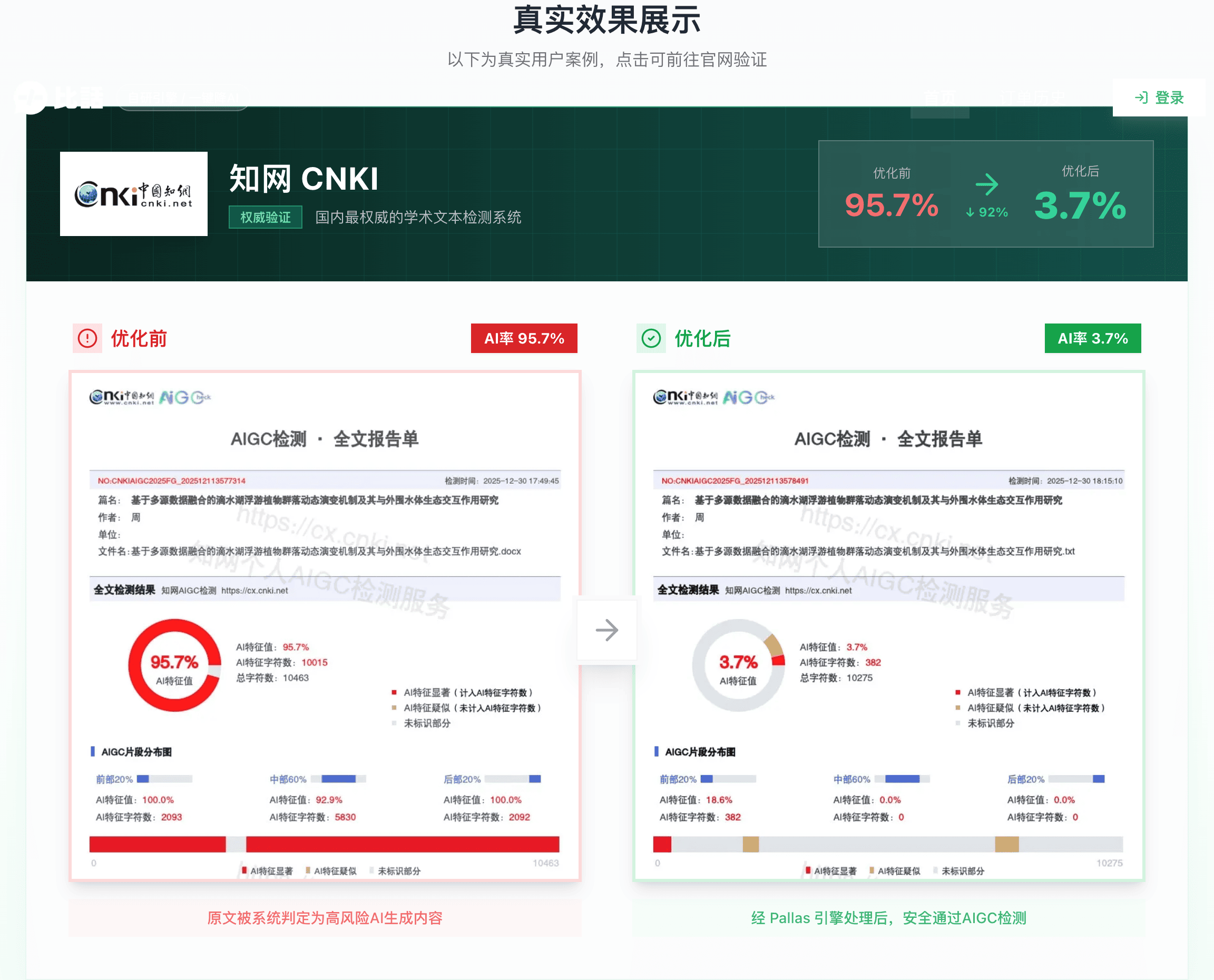

如果你的论文专业术语特别多(比如医学、计算机方向),我建议优先选比话降AI。它的Pallas引擎对知网最新算法做了定向优化,10亿+文本实测,而且承诺知网AI率降到15%以下,不达标全额退款。这个退款承诺其实能省不少心——至少你不用担心花了钱效果不行还退不了。

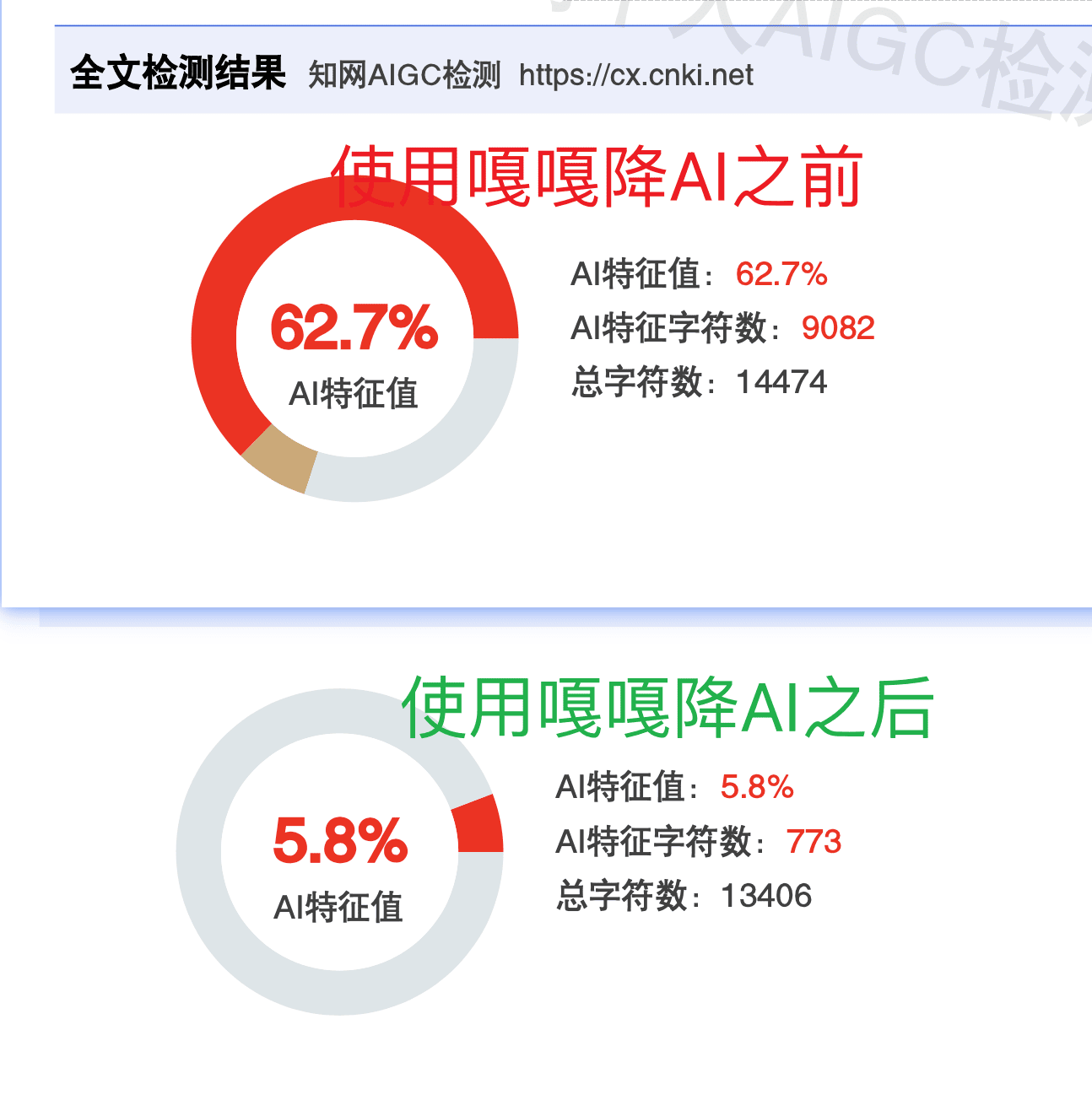

嘎嘎降AI(www.aigcleaner.com)也不错,达标率99.26%,支持知网、维普、万方等9个平台,适合需要多平台检测的情况。

预算紧张的话,率零(www.0ailv.com)的性价比很高,2元/千字起,新用户还有1000字免费体验。

常见问题

语义重构会改变论文原意吗? 不会。语义重构只改「怎么说」,不改「说什么」。核心观点、论据、数据全部保留,变的是句式结构和表达节奏。但处理完之后建议通读一遍,确保逻辑衔接没问题。

处理几次效果最好? 最多两次。多次处理会导致文本质量急剧下降,而且反复改写反而会引入新的统计规律性。实测下来,一次处理+人工微调是性价比最高的方案。

公式和代码段怎么处理? 公式尽量不动,代码段完全跳过。这些内容本身不会触发AIGC检测(检测算法主要看自然语言段落),强行修改反而容易出错。把处理精力集中在文献综述、讨论、结论这些文字密集的部分。

用DeepSeek手动改写能保护术语吗? 能,但你需要在提示词里明确标注。比如写「请改写以下段落,但保留以下术语不变:PCR扩增、引物设计、Tm值」。手动改写的好处是可控性强,缺点是慢——一篇万字论文可能要改大半天。如果时间紧,还是用专业工具更稳妥。

比话降AI的退款保障具体怎么操作? 使用知网平台检测后,如果AIGC率没降到15%以下,可以邮件申请退款。单笔订单超1.5万字符的,他们还会补偿检测费。7天内可以用同一订单号无限次重新处理,不额外收费。

如果你正好在为降AI伤术语的问题头疼,试试上面这套三步工作流。先标注术语 → 再用工具处理 → 最后人工核对,整个流程下来一篇论文大概1-2小时能搞定。

工具直达:

- 比话降AI:www.bihuapass.com(知网专攻,不达标退款)

- 嘎嘎降AI:www.aigcleaner.com(多平台兼容,达标率99.26%)

- 率零:www.0ailv.com(性价比首选,2元/千字起)